Wenn die Beziehung zwischen einem Datensatz von Prädiktorvariablen und einer Antwortvariablen linear ist, können wir Methoden wie die multiple lineare Regression verwenden, um die Beziehung zwischen den Variablen zu modellieren …

Die meisten überwachten Algorithmen für maschinelles Lernen basieren auf der Verwendung eines einzelnen Vorhersagemodells wie lineare Regression, logistische Regression, Ridge-Regression usw.

Methoden wie Bagging und Random Forests erstellen jedoch viele verschiedene Modelle, die auf wiederholten Bootstrap-Beispielen des ursprünglichen Datensatzes basieren. Vorhersagen für neue Daten werden getroffen, indem der Durchschnitt der Vorhersagen der einzelnen Modelle ermittelt wird.

Diese Methoden bieten tendenziell eine Verbesserung der Vorhersagegenauigkeit gegenüber Methoden, die nur ein einziges Vorhersagemodell verwenden, da sie den folgenden Prozess verwenden:

- Erstellen Sie zunächst einzelne Modelle mit hoher Varianz und geringer Verzerrung (z. B. tiefe Entscheidungsbäume).

- Nehmen Sie als nächstes den Durchschnitt der Vorhersagen, die von einzelnen Modellen gemacht wurden, um die Varianz zu verringern. Eine andere Methode, die dazu neigt, die Vorhersagegenauigkeit noch weiter zu verbessern, ist als Boosting bekannt.

Was ist Boosting?

Boosting ist eine Methode, die mit jedem Modelltyp verwendet werden kann, wird jedoch am häufigsten mit Entscheidungsbäumen verwendet.

Die Idee hinter dem Boosting ist einfach:

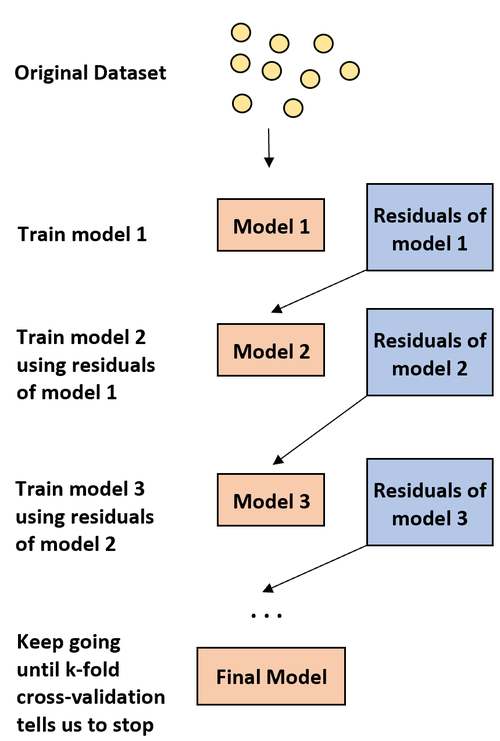

1. Erstellen Sie zunächst ein schwaches Modell.

- Ein „schwaches“ Modell ist eines, dessen Fehlerrate nur geringfügig besser ist als das zufällige Erraten.

- In der Praxis ist dies normalerweise ein Entscheidungsbaum mit nur einer oder zwei Teilungen.

2. Erstellen Sie als Nächstes ein weiteres schwaches Modell basierend auf den Residuen des vorherigen Modells.

- In der Praxis verwenden wir die Residuen des vorherigen Modells (d.h. die Fehler in unseren Vorhersagen), um ein neues Modell anzupassen, das die Gesamtfehlerrate geringfügig verbessert.

3. Setzen Sie diesen Prozess fort, bis die k-fache Kreuzvalidierung uns auffordert, aufzuhören.

- In der Praxis verwenden wir die k-fache Kreuzvalidierung, um zu ermitteln, wann wir mit dem Wachstum des Boosted-Modells aufhören sollten. Mit dieser Methode können wir mit einem schwachen Modell beginnen und dessen Leistung weiter steigern, indem wir nacheinander neue Bäume erstellen, die die Leistung des vorherigen Baums verbessern, bis wir ein endgültiges Modell mit hoher Vorhersagegenauigkeit erhalten.

Warum funktioniert Boosting?

Es stellt sich heraus, dass durch Boosting einige der leistungsstärksten Modelle im gesamtem Machine Learning Umfeld gebildet werden können.

In vielen Branchen werden Boosted-Modelle als Go-to-Modelle in der Produktion verwendet, da sie tendenziell alle anderen Modelle übertreffen.

Der Grund, warum Boosted-Modelle so gut funktionieren, ist das Verständnis einer einfachen Idee:

1. Erstens bilden Boosted-Modelle einen schwachen Entscheidungsbaum mit geringer Vorhersagegenauigkeit. Dieser Entscheidungsbaum soll eine geringe Varianz (engl. variance) und eine hohe Verzerrung (engl. bias) aufweisen.

2. Während Boosted-Modelle den Prozess der sequentiellen Verbesserung früherer Entscheidungsbäume durchlaufen, kann das Gesamtmodell die Verzerrung bei jedem Schritt langsam reduzieren, ohne die Varianz um ein Vielfaches zu erhöhen.

3. Das endgültig angepasste Modell weist tendenziell eine ausreichend niedrige Verzerrung (bias) und eine geringe Varianz (variance) auf, was zu einem Modell führt, das in der Lage ist, niedrige Testfehlerraten für neue Daten zu erzeugen.

Vor- und Nachteile von Boosting

Der offensichtliche Vorteil des Boostings besteht darin, dass Modelle hergestellt werden können, die im Vergleich zu fast allen anderen Modelltypen eine hohe Vorhersagegenauigkeit aufweisen.

Ein möglicher Nachteil ist, dass ein angepasstes Boosted-Modell sehr schwer zu interpretieren ist. Es bietet zwar eine enorme Möglichkeit, die Antwortwerte neuer Daten vorherzusagen, es ist jedoch schwierig, den genauen Prozess zu erklären, den es dazu verwendet.

In der Praxis erstellen die meisten Datenwissenschaftler und Praktiker des maschinellen Lernens Boosted-Modelle, weil sie die Antwortwerte neuer Daten genau vorhersagen möchten. Daher ist die Tatsache, dass Boosted-Modelle schwer zu interpretieren sind, normalerweise kein Problem.

Boosting in der Praxis

In der Praxis gibt es tatsächlich viele Arten von Algorithmen, die zum Boosting verwendet werden, einschließlich:

Abhängig von der Größe Ihres Datensatzes und der Verarbeitungsleistung Ihres Computers ist eine dieser Methoden möglicherweise der anderen vorzuziehen.

Eine Einführung in Bagging beim maschinellen Lernen

Eine einfache Einführung in Random Forests

Wenn die Beziehung zwischen einer Reihe von Prädiktorvariablen und einer Antwortvariablen sehr komplex ist, verwenden wir häufig nichtlineare Methoden, um die Beziehung zwischen ihnen zu modellieren.

Eine solche Methode sind …